Глава Tesla и основатель Space X Илон Маск призвал создателей искусственного интеллекта на время приостановить его развитие. Почему он считает развитие нейросетей угрозой для человечества, попытались разобраться журналисты издания rsute.ru.

Почему Илон Маск подписал открытое письмо против развития нейросетей

28 марта 2023 года на сайте организации Future of Life Institute (Институт будущего жизни) появилось открытое письмо, подписанное группой ученых и экспертов, призывающих приостановить активное развитие искусственного интеллекта.

Среди подписей оказалась и подпись известного бизнесмена Илона Маска. Группа ученых и исследователей считает, что активное использование нейросетей таит в себе скрытую угрозу для человечества, и их развитие должно быть приостановлено, во всяком случае до тех пор, пока не будет уверенности в их полной безопасности и управляемости человеком.

В открытом письме подробно описываются риски, которые может иметь дальнейшее развитие искусственного интеллекта, основным из которых называется опасность вступления в конкуренцию с людьми.

На данном этапе, пока интеллект нейронных сетей уступает интеллекту человека, бояться нечего, опасность представляет ситуация, когда это может поменяться. Поэтому прежде чем продолжить работу в этом направлении, важно обезопасить человечество от такой возможности. Для этого должны быть созданы надежные протоколы безопасности.

Какую опасность несет искусственный интеллект

Как считает Илон Маск, развитие искусственного интеллекта открывает перед людьми огромные возможности, но и создает громадные риски. Кроме опасности превысить интеллект человека и выйти из-под его контроля, существуют и другие негативные последствия использования искусственного интеллекта.

В частности есть опасность, что в скором будущем машины могут лишить многих людей их любимой работы и свести к нулю образование. Уже известны случаи, когда некоторые студенты при помощи нейросетей за сутки писали уникальные дипломные работы и защищали их.

По мнению Илона Маска, об исключении этих рисков необходимо подумать уже сейчас. Он считает, что если правильно построить работу, необходимые протоколы безопасности можно создать за полгода, но на этот период нужно приостановить дальнейшее развитие нейросетей. При этом соблюдение условий перерыва должны будут контролировать независимые эксперты.

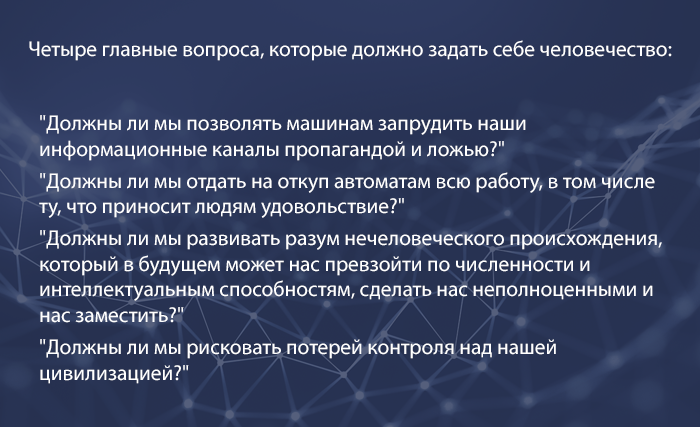

В открытом письме ученые призвали всех ответить себе на ряд вопросов, которые они опубликовали в своем обращении.